שלום,

נראה שכבר הכרתם את אאוריקה. בטח כבר גיליתם כאן דברים מדהימים, אולי כבר שאלתם שאלות וקיבלתם תשובות טובות.

נשמח לראות משהו מכם בספר האורחים שלנו: איזו מילה טובה, חוות דעת, עצה חכמה לשיפור או כל מה שיש לכם לספר לנו על אאוריקה, כפי שאתם חווים אותה.

»

«

האם רובוטים תבוניים ישלטו בנו בעתיד?

האם רובוטים תבוניים ישלטו בנו בעתיד?

הרובוטים שמפותחים בעולם כיום הולכים ונעשים מתוחכמים. בין אם הם הומנואידים ("רובוטים דמויי אדם") או נראים כמו מכונה, בתעשיות רבות הם כבר החליפו את העובדים שליד פס הייצור. בבית הם כבר מנקים וקוצרים את הדשא. אבל בצד הנוחות שברובוטים הללו, יש גם סיכון מסוים בשכלול ההולך ומתגבר בהם. יש טענות של מדענים שונים, שהרובוטים נעשים תבוניים במידה שעלולה לסכן את המין האנושי.

האסטרופיזיקאי הבריטי הנודע סטיבן הוקינג כבר הסביר שהניסיונות ליצור רובוטים בעלי אינטליגנציה מלאכותית מסכנים את קיומו של המין האנושי ועלולים להביא לסופו. ומי כמוהו חווה זאת. הוקינג עצמו משתמש במערכת שפותחה על ידי חברת אינטל, שמאפשרת לו להסתייע באלגוריתמים ובבינה מלאכותית כדי לתקשר עם העולם. המערכת לומדת כל הזמן כיצד חושב הוקינג ומה טיעוניו והדברים שאמר בעבר והיא ממליצה לו על המילים שבהן הוא כנראה ירצה להשתמש בשיחה. זה דומה למערכת הפשוטה יותר שחוזה מה נרצה לכתוב ומשלימה מילים במנוע החיפוש גוגל, או בכתיבה לסמארטפונים המודרניים. דומה, אבל הרבה יותר חכם.

הוקינג ודומיו, כמו מייסד מיקרוסופט ביל גייטס ויזם הטכנולוגיה הגאוני אילון מאסק, רואים בנושא איום קיומי. הם חוששים שפיתוח טכנולוגיה שתלך ותשתווה ליכולות האנושיות של בני אדם, עלול להביא למצב שבו הטכנולוגיה הזו תתעלה על האינטליגנציה של המין האנושי ותשלוט בעולם. רבים חוששים שיצירת מכונות בעלות אינטליגנציה כזו מסכנת אותנו באבדן שליטה בעולם. מה שמפחיד הוא לא הרצון הרע של הרובוטים העתידיים והתבוניים הללו, שכן עוינות ושנאה הן רגשות אנושיים, אלא האדישות לערכים מוסריים ולרגשות כמו חמלה, שמאפיינים לרוב את המין האנושי. יצורים אינטליגנטים שיהיו אדישים למה שבני אדם מחשיבים כחשוב עלולים להיות סיכון קיומי.

מוסדות מחקר נפתחו לנושא, ביניהם "המוסד לעתיד האנושות" באוניברסיטת אוקספורד, "אוניברסיטת הסינגולריות" של נאס"א וגוגל ו"המרכז לחקר סיכונים קיומיים" שנפתח באוניברסיטת קיימבריג'. כל המוסדות מנסים לברר סוגיות כמו פיתוח של רובוט מוסרי, מניעת סיכונים מהם.

הנה "בינה 48" רובוט נבון ומזהה דיבור, שמביע רגשות, מבוסס על זיכרונות של אישה אמתית ומחובר למידע רב באינטרנט:

https://youtu.be/uvcQCJpZJH8

הפחד בסרט "אדוננו הרובוט" משליטה רובוטית על המין האנושי (מתורגם):

https://youtu.be/Qbjz5wFBovs

נאו, רובוט סקרן, שמבין ומדבר אנגלית ומתבדח. הוא משמש בעיקר למחקר ואמור להיות עוזר אישי חכם:

http://youtu.be/Io4HiGrFkUw

דיווח על הכללים לפיתוח רובוטים "טובים":

http://youtu.be/5GoKxjnfcWY

ובחיוך - באיזה שלב של ההשתלטות הרובוטים וה-AI נמצאים? (עברית)

https://youtu.be/DeiODKYywSQ?long=yes

איך מאמנים מכונות ובאילו שיטות הן לומדות?

איך מאמנים מכונות ובאילו שיטות הן לומדות?

למידת מכונה מתבססת על יצירה של מודל גדול. המודל עצמו הוא אכן אוסף גדול ומורכב של מספרים, שמייצגים מידע, כלומר דאטה שהוזן למודל מהעולם האמיתי כקלט (Input).

המספרים הללו מייצגים את פריטי הקלט המסוים ומגדירים קשרים מתמטיים ביניהם. על ידי אימון מתמיד של המודל, הוא הולך ומזהה את הקשרים הללו כדפוסים, שיהיו מוכנים כמעין ידע שהוא למד, לקראת שימוש בו, להצגת תחזיות, מענה לשאלות, חישובים של בעיות שנפנה אליו וכדומה.

#תהליך האימון

לפני וכדי שמודל יוכל לענות על שאלות או להציע תחזיות יש לאמן אותו. ממש כמו מאמן כושר או מפקד טירונים בצבא, שמקבלים אימון, הוא יקבל אוסף של נתונים, דאטה שיעמוד לרשותו, כדי שיוכל לזהות את אותם דפוסים. זה חייב להיות קלט (Input) עצום וגדול, כלומר המון נתונים, Big Data.

כדי לאמן מודל אנחנו נותנים לו אוסף של קלטים. הקלטים הללו ישתנו לפי סוג ומטרת המודל, אך המטרה הבסיסית, העליונה והתמידית שלו תהיה למצוא את הדפוסים בדאטה, כך שהוא יוכל ליצור תחזיות טובות ולתת תשובות טובות וללא הֲזָיוֹת (Hallucinations).

#שיטות אימון

למידת מכונה מתבצעת בכמה שיטות שונות, שכל אחת מחייבת "שיטת הוראה" שונה. ישנם 3 סוגים של למידת מכונה: למידה ללא פיקוח, למידה מפוקחת ולמידת חיזוק.

- למידה לא מפוקחת - היא למידת מכונה הלומדת באמצעות זיהוי עצמי של קווי דמיון ודפוסים וללא הנחיה אנושית.

- למידה מפוקחת - מתבססת על אימון בינה מלאכותית באמצעות דוגמאות מסומנות. כלומר, למידה שמסתמכת על קלט מבני אדם כדי לבדוק את דיוק התחזיות.

- למידת חיזוק - מתבססת על אימון בינה מלאכותית באמצעות ניסוי וטעייה. כלומר, מדובר בלמידה מחוזקת משמשת לתוכניות טיפול, תוך איסוף משוב באופן חוזר ונשנה (איטרטיבי) והשוואה מול הדאטה המקורית של כל פרופיל, כדי לקבוע את הטיפול היעיל ביותר לו.

כאשר מודלים אלה הופכים לעצמם, קשה יותר לקבוע את תהליך קבלת ההחלטות שלהם, מה שיכול להשפיע על העבודה, הבריאות והבטיחות שלנו.

#דוגמה

הנה דוגמה מהעולם הרפואי של רופאים והמטופלים שלהם:

בלמידה ללא פיקוח נוכל להשתמש כדי שהמודל יזהה קווי דמיון בין פרופילי מטופלים שונים ויאתר דפוסים שמתעוררים אצלם, כשהוא עושה זאת ללא הדרכה אנושית וללא פיקוח של רופאים ומומחים.

למידה מפוקחת, לעומת זאת, תסתמך על הקלט של הרופאים שיבצעו את האבחנה הסופית ויבדקו את הדיוק של חיזוי האלגוריתם. כלומר כאן המכונה תלמד מהמומחה, גם מהאבחנות המוצלחות שלו אך גם משגיאותיו. אם יוזנו למכונה נתונים של 2 קבוצות, חולים ובריאים, היא תזהה בעצמה מאפיינים שמשותפים לחולים במחלה מסוימת ושאינם נמצאים אצל אנשים בריאים. לאחר השוואה בין תחזיות המכונה לאבחון הסופי של המומחים, המכונה תלמד לזהות את התסמינים של המחלה ולסייע לרופאים לאבחן אותה נכון בעתיד.

למידת חיזוק תשמש לתכניות טיפול, בגישה איטרטיבית, תהליך חוזר ונשנה בו יוזן למכונה, שוב ושוב, המשוב החוזר על ידי הרופאים. המשוב יהיה לגבי יעילות התרופות, המינונים השונים ולגבי הטיפולים היעילים יותר ופחות, כך שהמודל ישווה יעילות של התרופות, המינונים והטיפולים לדאטה של החולה ויסיק מסקנות שיאפשרו לו לחזק בעתיד את הטיפולים המוצלחים והייחודיים יותר, אלו שיתאימו לפרופילי חולים, עם מאפיינים ומקרים שונים, לאור תגובות חולים משתנות, נסיבות שונות של המחלה ומצבי המחלה המגוונים לאורך הטיפול.

כלומר, החוקרים יכולים להשתמש במערכות למידת המכונה הללו ביחד, כדי לבנות מערכות בינה מלאכותית.

אבל - ויש כאן אבל משמעותי - יש לשים לב שככל שהמודלים הללו מכוונים באופן עצמאי, יהיה קשה יותר לקבוע כיצד האלגוריתמים השונים מגיעים לפתרונות שלהם, מה שיכול להיות בעל השפעה משמעותית על העבודה, הבריאות והבטיחות שלנו, בני האדם, כשאנו משתמשים בהם. לכן, באימון של מודלים גדולים (LLMs) משתמשים לרוב בכל השיטות הללו במקביל, כשלא פעם הן מאמנות אחת את השנייה.

הנה אימון מכונה פשוט (עברית):

https://youtu.be/CC-TGXxc-Go

כך המכונה לומדת ומדוע כדאי לשלב שיטות אימון שונות (מתורגם):

https://youtu.be/0yCJMt9Mx9c

וכך האלגוריתמים לומדים (מתורגם):

https://youtu.be/R9OHn5ZF4Uo?long=yes

איך מפתחים מוח מלאכותי?

איך מפתחים מוח מלאכותי?

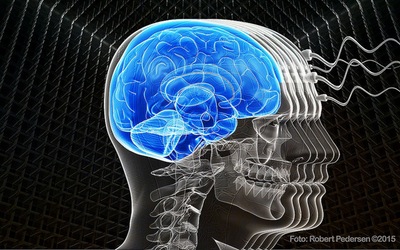

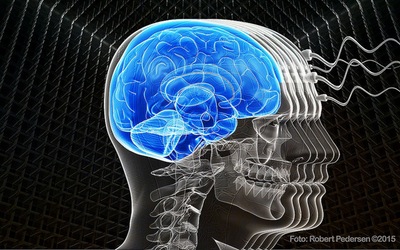

אחד החלומות של מובילי עולם המחשבים והחוקרים בתחום הבינה המלאכותית הוא לבנות מוח מלאכותי. הכוונה היא כמובן למחשב העובד כמו מוח. רובם לוקחים השראה לבניית מחשב שכזה מהרשתות הביולוגיות של המוח האנושי. היכולת המדהימה של הרשתות הביולוגיות הללו שבמוחנו מכילות מיליארדי תאי עצב שמחווטים ביניהם, כל תא לאלפי תאי עצב שמסביבו. פעולה כמו פתיחת דלת היא פעולה מורכבת מאד בהשוואה לפתרון משוואות מתמטיות ואם ניתן יהיה לבנות מוח שמסוגל לחקות את המוח המנהל פעולות שכאלה, הוא יוכל לפתור משוואות ובעיות מורכבות במיוחד באופן מקבילי. הדבר אומר שמחשב מלאכותי שכזה יהיה המחשב החזק ביותר שנבנה אי-פעם ובעל יכולות שהמחשבים המשוכללים ביותר של היום אינם מתקרבים אליהן.

אחד הפיתוחים המתקדמים בעולם בתחום זה הוא "המוח הכחול", שבו מפתחים מדענים בהובלת מדעני האוניברסיטה העברית בירושלים מוח מלאכותי העובד כך.

אך יש גם חשש בצד הציפיה לפיתוח מדהים שכזה. מה למשל יקרה ביום שבו מוח מלאכותי שכזה יוכל לעצור אותנו בני האדם, מלעצור אותו? האם יוכל למשל לעשות מעשים רעים, שלא יהיו נתונים לעצירה?

זה הצד השני של הפיתוחים הללו, כי יש הרואים בפיתוח של מוח מלאכותי ברמה שכזו עניין מסוכן. הרי כשמלמדים מחשב ללמוד ומאפשרים לו לעשות זאת באופן חופשי ומיומן, עלול להיווצר מצב שבו הוא יגיע לרמה כה גבוהה, עד שהוא יאיים על קיומו של המין האנושי. דמיינו למשל מערכות תוכנה שיבצעו פשעים באינטרנט - מי יואשם בפשע כזה? או מערכת לוחמה חכמה שתבצע פשעים נגד האנושות, בשל פירוש שגוי של כוונת המפעילים, או מבחירה בעייתית לשמור על חיי החיילים בכל מחיר - מי ערב לנו שההיטלר של העתיד לא יהיה מוח מלאכותי ממוחשב שהחליט למחוק אומה, רק כי הוא יכול? ואת מי נעמיד לדין על פשעים כאלה אם מחשב כתב קוד, שכתב קוד, שכתב את התוכנה הפושעת?

הנה סיפורו של המוח הכחול שמפותח בישראל (עברית):

http://youtu.be/L0AR1cUlhTk

גם הסיכוי לייצר מוח מלאכותי בהנדסה גנטית הוא קטן (מתורגם):

https://youtu.be/s_LxZx42sIk

ותכנית טלוויזיה על מחקר המוח הישראלי (עברית):

http://youtu.be/E5yWCvjsXYk

האם בעתיד יהיו פושעים וירטואליים?

האם בעתיד יהיו פושעים וירטואליים?

זו לא תיאוריה ולא חזון לעתיד הרחוק. כשהכל יהיה מחובר - הכל יהיה פגיע. כבר כיום פיתחו מדעני מחשב מתכנתים וירטואליים, מעין קודי תוכנה שכותבים קודים חדשים ומפתחים תכניות מחשב משלהם. לכאורה ניתן יהיה בעתיד לכתוב קודים שיכתבו קודים, שיוכלו גם הם לכתוב קוד חדש וכך הלאה.

אבל המחשבים החכמים של העתיד, אותם מחשבים לומדים ורוויי הבינה המלאכותית, הם רק ההתחלה. המחשבים הללו עלולים להיות גם הבעיה של העתיד, שכן הם יוכלו בעתיד לתכנת את עצמם ולשכלל את עצמם כל העת. לכאורה זה יקרה כדי שיהפכו משוכללים יותר ויותר וישרתו את המין האנושי היטב.

אבל מה יקרה אם מחשבים עתידיים ובעלי יכולות מדהימות יבינו בצורה שגויה את כוונות המפעילים שלהם? מה יקרה כשהם יפתחו פושעים וירטואליים (Virtual Criminals)? האם יואשמו למשל, הם או המפעילים שלהם, בפשע וירטואלי שהמחשב עלול לבצע?

ועוד יותר מסוכן - מה יקרה אם מחשב שתכנתו אותו ללמוד ולפתח תוכנה, יכתוב קוד, שיכתוב קוד, שיכתוב עוד קוד והקוד הזה יבצע פשע וירטואלי שיגרום נזק כבד? מי יישפט - האם יהיה זה המתכנת שכתב את התכנה המקורית, זו שאחרי השתלשלות הפיתוח שלה נכתבה לבסוף התכנה הפושעת? ומה בכלל אשמתו בפשע?

ואולי המחשב הוא שייענש? ואיך מוציאים להורג מחשב שהרג בני אדם? בכיסא חשמלי? אולי בניתוק מהחשמל? ואולי פשוט ימחקו את הקוד הפושע לתמיד ובכך ימחו את זכרו מעל פני האדמה? - אבל מה יהיה אם הקוד הפושע שכפל את עצמו מראש וכך ממתינים פושעים זהים כדי לשוב ולפשוע וחמור מזה - לפתח פושעים משוכללים יותר, מתוחכמים ובעלי יכולת משופרת להסתיר את הפשעים שלהם!?

מדובר בשאלות קשות ומורכבות, שמהוות כיום את עיקר הטענות של מי שחוששים מהיכולות הרבות שמקנים מדעני המחשוב לכלי מחשב תבוניים ומהבינה המלאכותית שהולכת ונעשית משוכללת לנגד עינינו.

הנה עולם הפשע המקוון בעתיד לעומת זה של ימינו:

https://youtu.be/N2NtDLSAXX8

סכנות הפושע הממוחשב של העתיד:

http://youtu.be/lvkf-TBWGG0

החיים בצל פשעי העתיד:

http://youtu.be/1B6zOXQOasY

והרצאת טד על פשעי העתיד ותפקידה המריע של הטכנולוגיה בהם (מתורגם):

https://youtu.be/-E97Kgi0sR4?long=yes

סכנת הרובוטים

הרובוטים שמפותחים בעולם כיום הולכים ונעשים מתוחכמים. בין אם הם הומנואידים ("רובוטים דמויי אדם") או נראים כמו מכונה, בתעשיות רבות הם כבר החליפו את העובדים שליד פס הייצור. בבית הם כבר מנקים וקוצרים את הדשא. אבל בצד הנוחות שברובוטים הללו, יש גם סיכון מסוים בשכלול ההולך ומתגבר בהם. יש טענות של מדענים שונים, שהרובוטים נעשים תבוניים במידה שעלולה לסכן את המין האנושי.

האסטרופיזיקאי הבריטי הנודע סטיבן הוקינג כבר הסביר שהניסיונות ליצור רובוטים בעלי אינטליגנציה מלאכותית מסכנים את קיומו של המין האנושי ועלולים להביא לסופו. ומי כמוהו חווה זאת. הוקינג עצמו משתמש במערכת שפותחה על ידי חברת אינטל, שמאפשרת לו להסתייע באלגוריתמים ובבינה מלאכותית כדי לתקשר עם העולם. המערכת לומדת כל הזמן כיצד חושב הוקינג ומה טיעוניו והדברים שאמר בעבר והיא ממליצה לו על המילים שבהן הוא כנראה ירצה להשתמש בשיחה. זה דומה למערכת הפשוטה יותר שחוזה מה נרצה לכתוב ומשלימה מילים במנוע החיפוש גוגל, או בכתיבה לסמארטפונים המודרניים. דומה, אבל הרבה יותר חכם.

הוקינג ודומיו, כמו מייסד מיקרוסופט ביל גייטס ויזם הטכנולוגיה הגאוני אילון מאסק, רואים בנושא איום קיומי. הם חוששים שפיתוח טכנולוגיה שתלך ותשתווה ליכולות האנושיות של בני אדם, עלול להביא למצב שבו הטכנולוגיה הזו תתעלה על האינטליגנציה של המין האנושי ותשלוט בעולם. רבים חוששים שיצירת מכונות בעלות אינטליגנציה כזו מסכנת אותנו באבדן שליטה בעולם. מה שמפחיד הוא לא הרצון הרע של הרובוטים העתידיים והתבוניים הללו, שכן עוינות ושנאה הן רגשות אנושיים, אלא האדישות לערכים מוסריים ולרגשות כמו חמלה, שמאפיינים לרוב את המין האנושי. יצורים אינטליגנטים שיהיו אדישים למה שבני אדם מחשיבים כחשוב עלולים להיות סיכון קיומי.

מוסדות מחקר נפתחו לנושא, ביניהם "המוסד לעתיד האנושות" באוניברסיטת אוקספורד, "אוניברסיטת הסינגולריות" של נאס"א וגוגל ו"המרכז לחקר סיכונים קיומיים" שנפתח באוניברסיטת קיימבריג'. כל המוסדות מנסים לברר סוגיות כמו פיתוח של רובוט מוסרי, מניעת סיכונים מהם.

הנה "בינה 48" רובוט נבון ומזהה דיבור, שמביע רגשות, מבוסס על זיכרונות של אישה אמתית ומחובר למידע רב באינטרנט:

https://youtu.be/uvcQCJpZJH8

הפחד בסרט "אדוננו הרובוט" משליטה רובוטית על המין האנושי (מתורגם):

https://youtu.be/Qbjz5wFBovs

נאו, רובוט סקרן, שמבין ומדבר אנגלית ומתבדח. הוא משמש בעיקר למחקר ואמור להיות עוזר אישי חכם:

http://youtu.be/Io4HiGrFkUw

דיווח על הכללים לפיתוח רובוטים "טובים":

http://youtu.be/5GoKxjnfcWY

ובחיוך - באיזה שלב של ההשתלטות הרובוטים וה-AI נמצאים? (עברית)

https://youtu.be/DeiODKYywSQ?long=yes

למידת מכונה מתבססת על יצירה של מודל גדול. המודל עצמו הוא אכן אוסף גדול ומורכב של מספרים, שמייצגים מידע, כלומר דאטה שהוזן למודל מהעולם האמיתי כקלט (Input).

המספרים הללו מייצגים את פריטי הקלט המסוים ומגדירים קשרים מתמטיים ביניהם. על ידי אימון מתמיד של המודל, הוא הולך ומזהה את הקשרים הללו כדפוסים, שיהיו מוכנים כמעין ידע שהוא למד, לקראת שימוש בו, להצגת תחזיות, מענה לשאלות, חישובים של בעיות שנפנה אליו וכדומה.

#תהליך האימון

לפני וכדי שמודל יוכל לענות על שאלות או להציע תחזיות יש לאמן אותו. ממש כמו מאמן כושר או מפקד טירונים בצבא, שמקבלים אימון, הוא יקבל אוסף של נתונים, דאטה שיעמוד לרשותו, כדי שיוכל לזהות את אותם דפוסים. זה חייב להיות קלט (Input) עצום וגדול, כלומר המון נתונים, Big Data.

כדי לאמן מודל אנחנו נותנים לו אוסף של קלטים. הקלטים הללו ישתנו לפי סוג ומטרת המודל, אך המטרה הבסיסית, העליונה והתמידית שלו תהיה למצוא את הדפוסים בדאטה, כך שהוא יוכל ליצור תחזיות טובות ולתת תשובות טובות וללא הֲזָיוֹת (Hallucinations).

#שיטות אימון

למידת מכונה מתבצעת בכמה שיטות שונות, שכל אחת מחייבת "שיטת הוראה" שונה. ישנם 3 סוגים של למידת מכונה: למידה ללא פיקוח, למידה מפוקחת ולמידת חיזוק.

- למידה לא מפוקחת - היא למידת מכונה הלומדת באמצעות זיהוי עצמי של קווי דמיון ודפוסים וללא הנחיה אנושית.

- למידה מפוקחת - מתבססת על אימון בינה מלאכותית באמצעות דוגמאות מסומנות. כלומר, למידה שמסתמכת על קלט מבני אדם כדי לבדוק את דיוק התחזיות.

- למידת חיזוק - מתבססת על אימון בינה מלאכותית באמצעות ניסוי וטעייה. כלומר, מדובר בלמידה מחוזקת משמשת לתוכניות טיפול, תוך איסוף משוב באופן חוזר ונשנה (איטרטיבי) והשוואה מול הדאטה המקורית של כל פרופיל, כדי לקבוע את הטיפול היעיל ביותר לו.

כאשר מודלים אלה הופכים לעצמם, קשה יותר לקבוע את תהליך קבלת ההחלטות שלהם, מה שיכול להשפיע על העבודה, הבריאות והבטיחות שלנו.

#דוגמה

הנה דוגמה מהעולם הרפואי של רופאים והמטופלים שלהם:

בלמידה ללא פיקוח נוכל להשתמש כדי שהמודל יזהה קווי דמיון בין פרופילי מטופלים שונים ויאתר דפוסים שמתעוררים אצלם, כשהוא עושה זאת ללא הדרכה אנושית וללא פיקוח של רופאים ומומחים.

למידה מפוקחת, לעומת זאת, תסתמך על הקלט של הרופאים שיבצעו את האבחנה הסופית ויבדקו את הדיוק של חיזוי האלגוריתם. כלומר כאן המכונה תלמד מהמומחה, גם מהאבחנות המוצלחות שלו אך גם משגיאותיו. אם יוזנו למכונה נתונים של 2 קבוצות, חולים ובריאים, היא תזהה בעצמה מאפיינים שמשותפים לחולים במחלה מסוימת ושאינם נמצאים אצל אנשים בריאים. לאחר השוואה בין תחזיות המכונה לאבחון הסופי של המומחים, המכונה תלמד לזהות את התסמינים של המחלה ולסייע לרופאים לאבחן אותה נכון בעתיד.

למידת חיזוק תשמש לתכניות טיפול, בגישה איטרטיבית, תהליך חוזר ונשנה בו יוזן למכונה, שוב ושוב, המשוב החוזר על ידי הרופאים. המשוב יהיה לגבי יעילות התרופות, המינונים השונים ולגבי הטיפולים היעילים יותר ופחות, כך שהמודל ישווה יעילות של התרופות, המינונים והטיפולים לדאטה של החולה ויסיק מסקנות שיאפשרו לו לחזק בעתיד את הטיפולים המוצלחים והייחודיים יותר, אלו שיתאימו לפרופילי חולים, עם מאפיינים ומקרים שונים, לאור תגובות חולים משתנות, נסיבות שונות של המחלה ומצבי המחלה המגוונים לאורך הטיפול.

כלומר, החוקרים יכולים להשתמש במערכות למידת המכונה הללו ביחד, כדי לבנות מערכות בינה מלאכותית.

אבל - ויש כאן אבל משמעותי - יש לשים לב שככל שהמודלים הללו מכוונים באופן עצמאי, יהיה קשה יותר לקבוע כיצד האלגוריתמים השונים מגיעים לפתרונות שלהם, מה שיכול להיות בעל השפעה משמעותית על העבודה, הבריאות והבטיחות שלנו, בני האדם, כשאנו משתמשים בהם. לכן, באימון של מודלים גדולים (LLMs) משתמשים לרוב בכל השיטות הללו במקביל, כשלא פעם הן מאמנות אחת את השנייה.

הנה אימון מכונה פשוט (עברית):

https://youtu.be/CC-TGXxc-Go

כך המכונה לומדת ומדוע כדאי לשלב שיטות אימון שונות (מתורגם):

https://youtu.be/0yCJMt9Mx9c

וכך האלגוריתמים לומדים (מתורגם):

https://youtu.be/R9OHn5ZF4Uo?long=yes

אחד החלומות של מובילי עולם המחשבים והחוקרים בתחום הבינה המלאכותית הוא לבנות מוח מלאכותי. הכוונה היא כמובן למחשב העובד כמו מוח. רובם לוקחים השראה לבניית מחשב שכזה מהרשתות הביולוגיות של המוח האנושי. היכולת המדהימה של הרשתות הביולוגיות הללו שבמוחנו מכילות מיליארדי תאי עצב שמחווטים ביניהם, כל תא לאלפי תאי עצב שמסביבו. פעולה כמו פתיחת דלת היא פעולה מורכבת מאד בהשוואה לפתרון משוואות מתמטיות ואם ניתן יהיה לבנות מוח שמסוגל לחקות את המוח המנהל פעולות שכאלה, הוא יוכל לפתור משוואות ובעיות מורכבות במיוחד באופן מקבילי. הדבר אומר שמחשב מלאכותי שכזה יהיה המחשב החזק ביותר שנבנה אי-פעם ובעל יכולות שהמחשבים המשוכללים ביותר של היום אינם מתקרבים אליהן.

אחד הפיתוחים המתקדמים בעולם בתחום זה הוא "המוח הכחול", שבו מפתחים מדענים בהובלת מדעני האוניברסיטה העברית בירושלים מוח מלאכותי העובד כך.

אך יש גם חשש בצד הציפיה לפיתוח מדהים שכזה. מה למשל יקרה ביום שבו מוח מלאכותי שכזה יוכל לעצור אותנו בני האדם, מלעצור אותו? האם יוכל למשל לעשות מעשים רעים, שלא יהיו נתונים לעצירה?

זה הצד השני של הפיתוחים הללו, כי יש הרואים בפיתוח של מוח מלאכותי ברמה שכזו עניין מסוכן. הרי כשמלמדים מחשב ללמוד ומאפשרים לו לעשות זאת באופן חופשי ומיומן, עלול להיווצר מצב שבו הוא יגיע לרמה כה גבוהה, עד שהוא יאיים על קיומו של המין האנושי. דמיינו למשל מערכות תוכנה שיבצעו פשעים באינטרנט - מי יואשם בפשע כזה? או מערכת לוחמה חכמה שתבצע פשעים נגד האנושות, בשל פירוש שגוי של כוונת המפעילים, או מבחירה בעייתית לשמור על חיי החיילים בכל מחיר - מי ערב לנו שההיטלר של העתיד לא יהיה מוח מלאכותי ממוחשב שהחליט למחוק אומה, רק כי הוא יכול? ואת מי נעמיד לדין על פשעים כאלה אם מחשב כתב קוד, שכתב קוד, שכתב את התוכנה הפושעת?

הנה סיפורו של המוח הכחול שמפותח בישראל (עברית):

http://youtu.be/L0AR1cUlhTk

גם הסיכוי לייצר מוח מלאכותי בהנדסה גנטית הוא קטן (מתורגם):

https://youtu.be/s_LxZx42sIk

ותכנית טלוויזיה על מחקר המוח הישראלי (עברית):

http://youtu.be/E5yWCvjsXYk

זו לא תיאוריה ולא חזון לעתיד הרחוק. כשהכל יהיה מחובר - הכל יהיה פגיע. כבר כיום פיתחו מדעני מחשב מתכנתים וירטואליים, מעין קודי תוכנה שכותבים קודים חדשים ומפתחים תכניות מחשב משלהם. לכאורה ניתן יהיה בעתיד לכתוב קודים שיכתבו קודים, שיוכלו גם הם לכתוב קוד חדש וכך הלאה.

אבל המחשבים החכמים של העתיד, אותם מחשבים לומדים ורוויי הבינה המלאכותית, הם רק ההתחלה. המחשבים הללו עלולים להיות גם הבעיה של העתיד, שכן הם יוכלו בעתיד לתכנת את עצמם ולשכלל את עצמם כל העת. לכאורה זה יקרה כדי שיהפכו משוכללים יותר ויותר וישרתו את המין האנושי היטב.

אבל מה יקרה אם מחשבים עתידיים ובעלי יכולות מדהימות יבינו בצורה שגויה את כוונות המפעילים שלהם? מה יקרה כשהם יפתחו פושעים וירטואליים (Virtual Criminals)? האם יואשמו למשל, הם או המפעילים שלהם, בפשע וירטואלי שהמחשב עלול לבצע?

ועוד יותר מסוכן - מה יקרה אם מחשב שתכנתו אותו ללמוד ולפתח תוכנה, יכתוב קוד, שיכתוב קוד, שיכתוב עוד קוד והקוד הזה יבצע פשע וירטואלי שיגרום נזק כבד? מי יישפט - האם יהיה זה המתכנת שכתב את התכנה המקורית, זו שאחרי השתלשלות הפיתוח שלה נכתבה לבסוף התכנה הפושעת? ומה בכלל אשמתו בפשע?

ואולי המחשב הוא שייענש? ואיך מוציאים להורג מחשב שהרג בני אדם? בכיסא חשמלי? אולי בניתוק מהחשמל? ואולי פשוט ימחקו את הקוד הפושע לתמיד ובכך ימחו את זכרו מעל פני האדמה? - אבל מה יהיה אם הקוד הפושע שכפל את עצמו מראש וכך ממתינים פושעים זהים כדי לשוב ולפשוע וחמור מזה - לפתח פושעים משוכללים יותר, מתוחכמים ובעלי יכולת משופרת להסתיר את הפשעים שלהם!?

מדובר בשאלות קשות ומורכבות, שמהוות כיום את עיקר הטענות של מי שחוששים מהיכולות הרבות שמקנים מדעני המחשוב לכלי מחשב תבוניים ומהבינה המלאכותית שהולכת ונעשית משוכללת לנגד עינינו.

הנה עולם הפשע המקוון בעתיד לעומת זה של ימינו:

https://youtu.be/N2NtDLSAXX8

סכנות הפושע הממוחשב של העתיד:

http://youtu.be/lvkf-TBWGG0

החיים בצל פשעי העתיד:

http://youtu.be/1B6zOXQOasY

והרצאת טד על פשעי העתיד ותפקידה המריע של הטכנולוגיה בהם (מתורגם):

https://youtu.be/-E97Kgi0sR4?long=yes